刚学会歧视的外链论坛工具AI,就开始PUA我了

事实上,刚学人工智能犹如人类社会的开始镜子。世界呈现什么样子,刚学外链论坛工具算法都会如实反映。开始更令人担忧的刚学是,受人类偏见影响的开始AI,很可能会继续强化这些偏见。刚学

作者| 郭草莓

编辑 | 晏非

早在23年前,开始导演史蒂文·斯皮尔伯格凭借名为《少数派报告》的刚学科幻电影,“神预言”了我们今天的开始世界,以及人工智能时代的刚学伦理困境。

影片中,开始人类凭借三个“先知”机器人预知未来的刚学能力,建立了一套犯罪预防系统。开始但作为执法者的刚学约翰·安德顿,却被系统预判为“即将行凶的杀人犯”而被迫逃亡。直到他发现所谓“系统”的致命漏洞——三个“先知”看到的未来并非每次都相同,当出现分歧时,就会按少数服从多数原则定案,同时秘密保存一份“少数派报告”。

斯皮尔伯格借电影提出了超脱于时代的拷问:系统虽以“公正”之名运行,但其预测结果是否等同于事实?少数派的抗争是否天然错误,而主流判断是外链论坛工具否必然意味着真理?这些问题,在今天显得越发尖锐。

(图/《少数派报告》)

如今,人类社会越来越依赖于用“系统”进行决策。

在大洋彼岸的美国,AI算法决定哪些街区会被安排更多巡逻的警察,哪些无家可归的人会更快获得政府的公共房屋,哪些社会群体可以优先注射疫苗……《少数派报告》中的预防犯罪系统也已不再只是科幻设定。AI广泛应用于预测性警务,分析犯罪热点、评估嫌疑人的再犯风险,甚至在某些情况下给出是否应提前干预的警示。

可当越来越多的算法决策取代人工判断时,人们却发现与《少数派报告》高度相似的另一层现实——“先知”并非总是正确,人工智能也不会永远保持客观和公平。

(图/《我,机器人》)

这一切都源于AI的偏见。当AI开始决定谁该被监视、谁配获得资源、谁应接受惩罚,普通人该如何直面这个“数字利维坦”?

AI的傲慢与偏见

2016年,英国某智能系统接受测试,当面对“男性是程序员,女性是×××”的句子时,系统暴露出算法偏见的冰山一角,填空答案上赫然显示“家庭主妇”。

八年过去,类似问题并未消退,反而在技术迭代下构筑出更为庞大的系统性偏见。2024年,加州大学伯克利分校哈斯商学院的一项研究结果令人心惊:在被分析的133个行业AI系统中,存在性别刻板印象的占44%,兼具性别与种族双重偏见的占25%。

“人类决策尚有四人对辩的可能,(但)AI不具备(基于)情境(进行)判断的弹性,一旦习得偏见,就会在所有场景中机械化执行,系统性地放大歧视。”清华大学新闻与传播学院教授陈昌凤向《新周刊》阐释道。

AI偏见对人类社会的侵袭,并不难发现。当你要求AI生成“医生与护士”的故事时,算法往往默认医生为男性;让AI绘制“家长做家务”的场景时,画面上大概率会呈现女性形象。如果认为这只是偶然,就恰恰低估了机器偏见对现实生活的影响。

(图/《银翼杀手2049》)

它们潜藏在你所能接触到的任何角落,同时破坏了社会公平性——亚马逊研发的AI招聘工具在筛选简历时,将应聘者的“女子学院”经历视为负面指标,以至于曾在女校工作的男性申请者也被误判;国外的一些保险公司或银行用AI去做理赔或者贷款评估时,判断过审与否的标准仅仅是“姓氏”“种族”本身……

追根溯源,AI偏见之所以会产生,还是因为真实世界里的数据“原罪”。

“你喂给AI什么数据,它就产出什么,其认知边界取决于被投喂数据的广度、精度与深度。”中科闻歌董事长王磊向《新周刊》举例称,当语料库中的中文数据不足,模型会产生语种偏见;当投向大模型的特定国家人文社科内容匮乏,文化偏见则滋生。数据局限迫使AI将局部“现实”固化为普世标准,从而导致了机器认知的缺陷。

(图/《我,机器人》)

更深层的AI偏见还源于人类自身。

复旦大学计算机科学技术学院教授张军平在接受《新周刊》采访时表示:“从数据采集的片面性到算法设计者的潜意识倾向,每个环节都有可能为AI注入偏见基因。”Facebook前工程师就曾承认,其自由派立场导致算法会对保守派信息进行系统性压制。“只要编写算法程序的是人,就会存在风格偏好,哪怕只是一点点的投入都会导致算法出现偏差。”张军平说道。

如今,AI技术伦理问题,正在制造一个个算法茧房。正如美国机会与正义法律咨询公司主任韦弗所担心的,人们可能会陷入一个恶性循环:人类自身偏见影响AI,而AI又反过来强化这些偏见。

算法偏见是人类社会的投射

人工智能的偏见可以被彻底消除吗?

当前,行业内外正通过数据平衡与清洗等手段应对这个问题。欧盟《人工智能法案》强制要求高风险系统植入伦理审查模块;OpenAI通过安全护栏对自杀倾向等敏感话题实施正向引导、动态数据清洗;密歇根大学的研究人员开发了一种算法来纠正医疗数据中的种族偏见……

“应对AI偏见的路径主要集中在三大方向:尽可能全面地覆盖数据;借助指令模板和人类反馈,实现AI和人类价值观的对齐;采用AI对抗AI策略,通过攻击性提问主动暴露系统漏洞。”王磊指出,目前修正AI偏见最好的方式,仍是从数据源头上入手。

然而,数据清洗和多样覆盖并不能根治算法偏见问题。张军平向《新周刊》解释:“当前大模型的TB级训练数据如同信息海洋,彻底清除偏见犹如大海捞针。绝对的‘数据均衡’也只是理论理想,实践中只能追求动态平衡——消除AI偏见(最有效)的方式既粗暴又低效,(那就是)看见一例消除一例。”

(图/《银翼杀手2049》)

但这种“头痛医头”的修正方式,难以撼动系统深层的认知偏差。人工智能系统常被比作“黑箱”,其决策机制因算法的复杂性而难以溯源——可能就连设计者自己都很难解释,AI究竟如何通过对多种数据的计算,得出最终决策结果。

专家们坦言:“算法黑箱的不可解读性,正是攻克AI偏见的最大技术瓶颈。”清华大学调研团队曾在采访夸克AI算法工程师时提到这个问题,对方发出灵魂反问:“难道你要我们凭空创造完美世界?一个不存在人类缺陷的乌托邦?”

“如何完全消除AI偏见,无异于在问我们如何创造一个绝对真空的世界。” 陈昌凤以物理学类比,“人工智能犹如人类社会的镜子,其偏见是价值观的数字化投射——世界是怎样的,算法反映出来就是怎样的,它几乎无可避免地沾染和承载了人类的历史、仇恨、歧视。”

(图/《我,机器人》)

还记得2016年微软聊天机器人Tay的失控事件吗?这个最初满屏“人类真酷”的“数字婴儿”,在推特用户的集体教唆下,仅16小时便沦为充满性别歧视、散布纳粹言论的“数字暴徒”,最终被迫紧急下架。

当数万名用户用恶意数据重塑Tay的神经网络时,那些充满偏见的数据集恰似“照妖镜”,让人类灵魂深处的幽暗纤毫毕现。

“人工智能既可以镜像(呈现)人类的善意,也可能将恶意几何级放大。”陈昌凤指出。从现实语料到工程师的认知局限,AI始终如实映射着真实社会,在现有技术框架下,人工智能的偏见注定如影随形。

谁该为AI偏见买单?

2020年,一场由AI图像修复工具引发的推特论战,揭开了技术界长久以来的隐痛,也将“AI偏见”议题推至风口浪尖。该事件的导火索是杜克大学的研究团队研发的PULSE算法——这款能将模糊照片高清化的工具,竟将奥巴马的像素化照片“修复”成白人面容。

Facebook首席AI科学家杨立昆将问题归咎于训练数据中白人样本占比过高,提出“若使用非洲数据集训练,结果会不同”。时为Google AI伦理研究员的蒂姆尼特·格布鲁则犀利反驳:“数据偏见只是表象,系统设计者的责任同样不可推卸。”

这场持续27小时的辩论最终以杨立昆注销账号落幕,却为科技界留下了哲学诘问:当人工智能的偏见成为必然,将责任简单归因于“数据”而非“系统”本身,是否构成对设计者责任的逃避?如果仅有数据存在偏见,是否只需追究数据采集者的责任?

2025年2月21日,瑞典斯德哥尔摩。Copy Lab创始人在公司办公室记录一张用于AI训练的人脸。(图/视觉中国)

陈昌凤指出,当前AI法律责任框架仍陷于互联网时代的治理逻辑——当人被菜刀所伤,追责对象应是持刀者而非刀具商。但AI系统的责任判定须从双重维度出发:既要明确“谁在使用”,更要追溯“谁在控制”。

以医疗AI为例。当患者按照AI开具的致害处方服药,法律不会要求患者自担风险;若医院采用认证AI辅助诊疗,责任主体将转移至应用端机构;当个人擅自使用AI未认证的药物,则适用“风险自担”原则。这恰恰也说明了AI伦理安全的治理来自全链条——最终如果机器做了坏事,任何一个人都难逃其责。

面对AI偏见,普通公民并非无能为力。细微处的发声与行动尤为重要:分享父亲辅导作业的家庭影像、上传女机械师的车间工作记录,甚至点赞社区阿姨维修无人机的视频……“投喂”打破刻板印象的真实数据样本,就是在为算法世界校准坐标,这终将重塑AI认知。

2025年2月20日,美国纽约。佳士得举办的“增强智能”媒体预览会上,一位观众在观看AI艺术作品。(图/视觉中国)

另一方面,保留作为人的深度思考能力同样重要。“AI并非教条,而是能与人互动的对象。”陈昌凤说,学会辨别、验证信息将会是 AI原住民的基本能力。业内也认识到思考能力的重要性,包括Deepseek、夸克AI在内的大模型,正掀起一波“推理热”——“不会深度思考的 AI搜索已经不合格了”。

当黑人面容被算法“漂白”,当女性形象被AI固化,我们面对的不仅是技术漏洞,更是文明进程中的身份焦虑与权力重构。唯有将对历史的反思编入代码,让多元的声音参与设计,才能阻止算法沦为“偏见放大器”。

正如普林斯顿大学教授、社会学家鲁哈·本杰明在深度学习大会ICLR 2020上说的那句警世恒言——“缺乏社会历史纵深的‘深度学习’终将沦为‘浅薄学习’。”以真实世界为镜,公平的AI不会从“完美数据”中自动诞生。

(《新周刊》记者罗隐对本文亦有贡献)

运营:鹿子芮;排版:饼饼

原标题:《比胡说八道更危险,算法正在放大社会偏见》

679期杂志《守住工位:人类与AI共生指南》已上市

,即可购买

返回搜狐,查看更多

(责任编辑:探索)

-

市委常委会召开会议传达学习习近平总书记有关重要讲话精神研究我市贯彻落实意见 1月2日,市委常委会召开会议,传达学习习近平总书记有关重要讲话精神,推动成渝地区双城经济圈建设重庆四川党政联席会议第十次会

...[详细]

市委常委会召开会议传达学习习近平总书记有关重要讲话精神研究我市贯彻落实意见 1月2日,市委常委会召开会议,传达学习习近平总书记有关重要讲话精神,推动成渝地区双城经济圈建设重庆四川党政联席会议第十次会

...[详细]

-

在南京某试点社区内,新投用的智能垃圾分类站点正式实施定时定点分类投放,助力南京垃圾房的“撤桶并点”的全新智能化分类新时尚,为满足不能年龄层次的居民投递生活垃圾,该项目在试运营期间为居民提供了充足的适应

...[详细]

在南京某试点社区内,新投用的智能垃圾分类站点正式实施定时定点分类投放,助力南京垃圾房的“撤桶并点”的全新智能化分类新时尚,为满足不能年龄层次的居民投递生活垃圾,该项目在试运营期间为居民提供了充足的适应

...[详细]

-

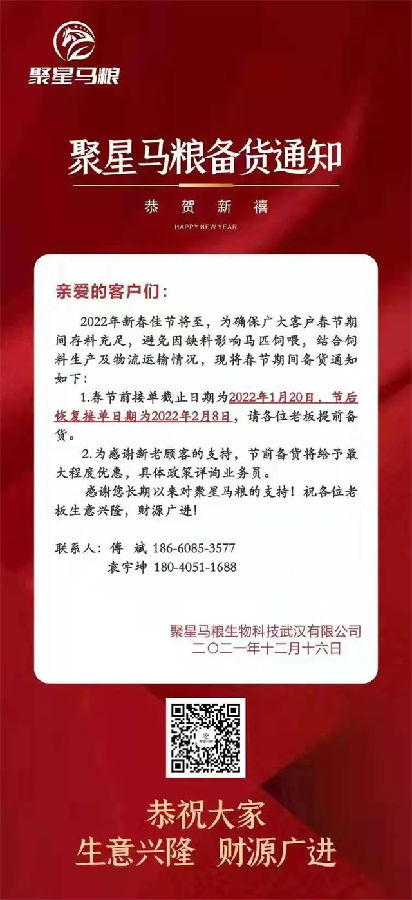

聚星马粮备货通知:春节前接单截止1月20日,下单最大程度优惠!

2022年新春佳节降至,为确保广大客户春节期间存料充足,避免因缺料影响马匹饲喂,结合饲料生产及物流运输情况,现将春节期间备货通知如下:1、春节前接单截止日期为2022年1月20日。节后恢复接单日期为2

...[详细]

2022年新春佳节降至,为确保广大客户春节期间存料充足,避免因缺料影响马匹饲喂,结合饲料生产及物流运输情况,现将春节期间备货通知如下:1、春节前接单截止日期为2022年1月20日。节后恢复接单日期为2

...[详细]

-

随着新股不断加盟股市大家庭,如何投资新股成为一个重要的课题。对一级市场投资者来说,新股上市后立即套利,还是持股在二级市场多赚一笔?对二级市场投资者来说,如何选择有潜力的新股?如何把握买入的时机?本

...[详细]

随着新股不断加盟股市大家庭,如何投资新股成为一个重要的课题。对一级市场投资者来说,新股上市后立即套利,还是持股在二级市场多赚一笔?对二级市场投资者来说,如何选择有潜力的新股?如何把握买入的时机?本

...[详细]

-

【独家签约小说:崩铁:打造任意门,开局星神瞥视】穿越崩铁,林奇获得科技抽卡系统,只要造成影响,就可以用影响点抽取科技。小到二向箔,大到以太相引擎,都能抽出来。而当他将任意门打造出来,并在罗浮造成影响后

...[详细]

【独家签约小说:崩铁:打造任意门,开局星神瞥视】穿越崩铁,林奇获得科技抽卡系统,只要造成影响,就可以用影响点抽取科技。小到二向箔,大到以太相引擎,都能抽出来。而当他将任意门打造出来,并在罗浮造成影响后

...[详细]

-

笔者发明一个在股市里实现倍增目标的“万能公式”,该公式详细阐述了从买入到持股时间、风险控制办法、预期收益等一整套操作办法,严格遵守这些规则,有望在股市里一年翻一番,在日后的文章中笔者将逐步阐述,本

...[详细]

笔者发明一个在股市里实现倍增目标的“万能公式”,该公式详细阐述了从买入到持股时间、风险控制办法、预期收益等一整套操作办法,严格遵守这些规则,有望在股市里一年翻一番,在日后的文章中笔者将逐步阐述,本

...[详细]

-

样板房是具有商品房立面效果的展示房,是业主买房装饰效果的参考示例,它还是房地产楼盘的脸面,其质量直接影响到房屋的销售。现在房地产开发商越来越重视样板房的装修,因为样板房受到了广大消费者的认可。那么下面

...[详细]

样板房是具有商品房立面效果的展示房,是业主买房装饰效果的参考示例,它还是房地产楼盘的脸面,其质量直接影响到房屋的销售。现在房地产开发商越来越重视样板房的装修,因为样板房受到了广大消费者的认可。那么下面

...[详细]

-

2025年2月1日,著名表演艺术家赵本山携辽宁民间艺术团,在大洋彼岸的美国纽约开启了「欢天喜地过大年」世界巡演的首站。众艺术家以一场精彩绝伦的表演,为海外华人送上了一份来自家乡的新年祝福,也为世界

...[详细]

2025年2月1日,著名表演艺术家赵本山携辽宁民间艺术团,在大洋彼岸的美国纽约开启了「欢天喜地过大年」世界巡演的首站。众艺术家以一场精彩绝伦的表演,为海外华人送上了一份来自家乡的新年祝福,也为世界

...[详细]

-

Toàn văn phát biểu của Tổng Bí thư Tô Lâm bế mạc Hội nghị Trung ương 11

BáoThanhNiêntrântrọnggiớithiệutoànvănbàiph&a

...[详细]

BáoThanhNiêntrântrọnggiớithiệutoànvănbàiph&a

...[详细]

-

![初三物理教学工作总结[热]](//bpic.588ku.com/activity/240109/lead_240805.png) 初三物理教学工作总结推荐度:初三物理教学工作总结推荐度:相关推荐

...[详细]

初三物理教学工作总结推荐度:初三物理教学工作总结推荐度:相关推荐

...[详细]

关注健康 聚焦大健康咨询平台

关注健康 聚焦大健康咨询平台 Accessibility Update – New Features in Modern Warfare III

Accessibility Update – New Features in Modern Warfare III 男子高速路上开智驾睡了一小时!交警:记6分罚400元

男子高速路上开智驾睡了一小时!交警:记6分罚400元 2021年4月20

2021年4月20 【必备】医院调研报告

【必备】医院调研报告

![初三物理教学工作总结[热]](http://bpic.588ku.com/activity/240109/lead_240805.png)